Erkennung von Inhaltsähnlichkeiten - Content similarity detection

Plagiaterkennung oder Inhaltsähnlichkeitserkennung ist der Prozess, bei dem Instanzen von Plagiaten oder Urheberrechtsverletzungen in einem Werk oder Dokument lokalisiert werden . Die weit verbreitete Nutzung von Computern und das Aufkommen des Internets haben es einfacher gemacht, die Arbeit anderer zu plagiieren.

Die Erkennung von Plagiaten kann auf verschiedene Weise erfolgen. Die Erkennung von Personen ist die traditionellste Form der Identifizierung von Plagiaten aus schriftlichen Arbeiten. Dies kann für den Leser eine langwierige und zeitraubende Aufgabe sein und kann auch zu Inkonsistenzen bei der Identifizierung von Plagiaten innerhalb einer Organisation führen. Text-Matching-Software (TMS), die auch als "Plagiat Detection Software" oder "Anti-Plagiarism"-Software bezeichnet wird, ist weit verbreitet, sowohl in Form von kommerziell erhältlichen Produkten als auch als Open-Source-Software. TMS erkennt Plagiate nicht per se, sondern findet stattdessen bestimmte Textpassagen in einem Dokument, die mit Texten in einem anderen Dokument übereinstimmen.

Softwaregestützte Plagiatserkennung

Die computergestützte Plagiatserkennung (CaPD) ist eine Informationsabruf (IR) -Aufgabe, die von spezialisierten IR-Systemen unterstützt wird und als Plagiaterkennungssystem (PDS) oder Dokumentähnlichkeitserkennungssystem bezeichnet wird. Eine systematische Literaturrecherche aus dem Jahr 2019 gibt einen Überblick über modernste Methoden zur Plagiatserkennung.

In Textdokumenten

Systeme zur Textähnlichkeitserkennung implementieren einen von zwei generischen Erkennungsansätzen, von denen einer extern und der andere intrinsisch ist. Externe Erkennungssysteme vergleichen ein verdächtiges Dokument mit einer Referenzsammlung, bei der es sich um eine Reihe von Dokumenten handelt, von denen angenommen wird, dass sie echt sind. Basierend auf einem ausgewählten Dokumentenmodell und vordefinierten Ähnlichkeitskriterien besteht die Erkennungsaufgabe darin, alle Dokumente abzurufen, die Text enthalten, der in einem Grad über einem gewählten Schwellenwert dem Text in dem verdächtigen Dokument ähnlich ist. Intrinsische PDS analysieren ausschließlich den zu bewertenden Text, ohne Vergleiche mit externen Dokumenten durchzuführen. Dieser Ansatz zielt darauf ab, Veränderungen im einzigartigen Schreibstil eines Autors als Indikator für potenzielle Plagiate zu erkennen. PDS sind nicht in der Lage, Plagiate ohne menschliches Urteil zuverlässig zu identifizieren. Ähnlichkeiten und Schreibstilmerkmale werden mit Hilfe vordefinierter Dokumentmodelle berechnet und können Fehlalarme darstellen.

Wirksamkeit dieser Instrumente im Hochschulbereich

Eine Studie wurde durchgeführt, um die Wirksamkeit von Software zur Erkennung von Ähnlichkeiten im Hochschulbereich zu testen. In einem Teil der Studie wurde eine Gruppe von Studierenden beauftragt, eine Arbeit zu schreiben. Diese Studenten wurden zunächst über Plagiate aufgeklärt und darüber informiert, dass ihre Arbeit ein System zur Erkennung von Inhaltsähnlichkeiten durchlaufen sollte. Eine zweite Gruppe von Studierenden wurde beauftragt, eine Arbeit ohne Angaben zu Plagiaten zu schreiben. Die Forscher erwarteten niedrigere Raten in Gruppe eins, fanden jedoch in beiden Gruppen ungefähr die gleichen Plagiatsraten.

Nähert sich

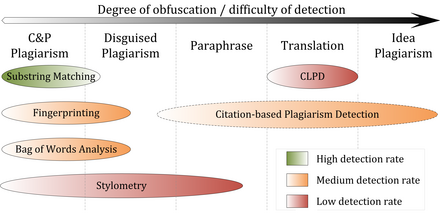

Die folgende Abbildung stellt eine Klassifizierung aller Erkennungsansätze dar, die derzeit zur computergestützten Inhaltsähnlichkeitserkennung verwendet werden. Die Ansätze zeichnen sich durch die Art der Ähnlichkeitsbewertung aus, die sie durchführen: global oder lokal. Globale Ansätze zur Ähnlichkeitsbewertung verwenden die Merkmale, die aus größeren Teilen des Textes oder des gesamten Dokuments entnommen wurden, um die Ähnlichkeit zu berechnen, während lokale Verfahren nur vorausgewählte Textsegmente als Eingabe untersuchen.

Fingerabdruck

Fingerabdrücke sind derzeit der am weitesten verbreitete Ansatz zur Erkennung von Inhaltsähnlichkeiten. Dieses Verfahren bildet repräsentative Auszüge von Dokumenten, indem ein Satz von mehreren Teilzeichenfolgen ( N-Grammen ) daraus ausgewählt wird. Die Sets stellen die Fingerabdrücke dar und ihre Elemente werden Minutien genannt. Ein verdächtiges Dokument wird auf Plagiate überprüft, indem sein Fingerabdruck berechnet und Details mit einem vorberechneten Fingerabdruckindex für alle Dokumente einer Referenzsammlung abgefragt werden. Minutien, die mit denen anderer Dokumente übereinstimmen, weisen auf gemeinsame Textsegmente hin und weisen auf ein potenzielles Plagiat hin, wenn sie eine gewählte Ähnlichkeitsschwelle überschreiten. Rechenressourcen und Zeit sind limitierende Faktoren für das Fingerprinting, weshalb diese Methode normalerweise nur eine Teilmenge von Details vergleicht, um die Berechnung zu beschleunigen und Überprüfungen in sehr großen Sammlungen wie dem Internet zu ermöglichen.

Zeichenfolgenabgleich

String Matching ist ein weit verbreiteter Ansatz in der Informatik. Bei der Anwendung auf das Problem der Plagiatserkennung werden Dokumente auf wörtliche Textüberlappungen verglichen. Zur Lösung dieser Aufgabe wurden zahlreiche Methoden vorgeschlagen, von denen einige an die externe Plagiatserkennung angepasst wurden. Die Überprüfung eines verdächtigen Dokuments in dieser Einstellung erfordert die Berechnung und Speicherung von effizient vergleichbaren Darstellungen für alle Dokumente in der Referenzsammlung, um sie paarweise zu vergleichen. Im Allgemeinen wurden für diese Aufgabe Suffix-Dokumentmodelle wie Suffix-Bäume oder Suffix-Vektoren verwendet. Nichtsdestotrotz bleibt das Abgleichen von Teilzeichenfolgen rechenintensiv, was es zu einer nicht praktikablen Lösung für die Überprüfung großer Dokumentensammlungen macht.

Beutel voller Worte

Die Bag-of-Words-Analyse repräsentiert die Übernahme des Vektorraum-Retrievals , eines traditionellen IR-Konzepts, in den Bereich der Inhaltsähnlichkeitserkennung. Dokumente werden als ein oder mehrere Vektoren dargestellt, zB für verschiedene Dokumentteile, die für paarweise Ähnlichkeitsberechnungen verwendet werden. Die Ähnlichkeitsberechnung kann sich dann auf das traditionelle Kosinus-Ähnlichkeitsmaß oder auf komplexere Ähnlichkeitsmaße stützen .

Zitationsanalyse

Die zitationsbasierte Plagiatserkennung (CbPD) basiert auf der Zitationsanalyse und ist der einzige Ansatz zur Plagiatserkennung, der sich nicht auf die textliche Ähnlichkeit verlässt . CbPD untersucht die Zitations- und Referenzinformationen in Texten, um ähnliche Muster in den Zitationssequenzen zu identifizieren . Daher eignet sich dieser Ansatz für wissenschaftliche Texte oder andere wissenschaftliche Dokumente, die Zitate enthalten. Die Zitationsanalyse zur Erkennung von Plagiaten ist ein relativ junges Konzept. Es wurde nicht von kommerzieller Software übernommen, aber es existiert ein erster Prototyp eines zitationsbasierten Plagiatserkennungssystems. Ähnliche Reihenfolge und Nähe der Zitate in den untersuchten Dokumenten sind die Hauptkriterien, die verwendet werden, um Ähnlichkeiten von Zitationsmustern zu berechnen. Zitationsmuster stellen Teilsequenzen dar, die nicht ausschließlich Zitate enthalten, die von den verglichenen Dokumenten geteilt werden. Faktoren, einschließlich der absoluten Anzahl oder des relativen Anteils gemeinsamer Zitate im Muster, sowie die Wahrscheinlichkeit, dass Zitate in einem Dokument gleichzeitig vorkommen, werden ebenfalls berücksichtigt, um den Ähnlichkeitsgrad der Muster zu quantifizieren.

Stilometrie

Stylometry subsumiert statistische Methoden zur Quantifizierung des einzigartigen Schreibstils eines Autors und wird hauptsächlich für die Zuschreibung der Autorenschaft oder die Erkennung von intrinsischen Plagiaten verwendet. Um ein Plagiat durch Zuschreibung der Autorenschaft zu erkennen, muss überprüft werden, ob der Schreibstil des verdächtigen Dokuments, das angeblich von einem bestimmten Autor verfasst wurde, mit dem eines Korpus von Dokumenten desselben Autors übereinstimmt. Die intrinsische Plagiatserkennung hingegen deckt Plagiate anhand interner Beweise im verdächtigen Dokument auf, ohne es mit anderen Dokumenten zu vergleichen. Dies geschieht, indem stilometrische Modelle für verschiedene Textsegmente des verdächtigen Dokuments erstellt und verglichen werden, und Passagen, die sich stilistisch von anderen unterscheiden, werden als potenziell plagiiert/verletzt markiert. Obwohl sie einfach zu extrahieren sind, haben sich Zeichen- N-Gramme als eines der besten stilometrischen Merkmale für die Erkennung von intrinsischen Plagiaten erwiesen.

Leistung

Vergleichende Auswertungen von Systemen zur Erkennung von Inhaltsähnlichkeiten zeigen, dass ihre Leistungsfähigkeit von der Art des vorliegenden Plagiats abhängt (siehe Abbildung). Mit Ausnahme der Zitationsmusteranalyse beruhen alle Erkennungsansätze auf textlicher Ähnlichkeit. Es ist daher symptomatisch, dass die Erkennungsgenauigkeit abnimmt, je mehr Plagiatsfälle verschleiert werden.

Wörtliche Kopien, auch Copy-and-Paste (c&p)-Plagiate oder eklatante Urheberrechtsverletzungen, oder bescheiden verschleierte Plagiatsfälle können von aktuellen externen PDS mit hoher Genauigkeit erkannt werden, wenn die Quelle für die Software zugänglich ist. Insbesondere Substring-Matching-Verfahren erzielen eine gute Performance für c&p-Plagiate, da sie üblicherweise verlustfreie Dokumentmodelle wie Suffixbäume verwenden . Die Leistung von Systemen, die Fingerabdruck- oder Bag-of-Word-Analyse verwenden, um Kopien zu erkennen, hängt vom Informationsverlust ab, der durch das verwendete Dokumentenmodell verursacht wird. Durch die Anwendung flexibler Chunking- und Selektionsstrategien sind sie im Vergleich zu Substring-Matching-Verfahren besser in der Lage, moderate Formen von getarntem Plagiat zu erkennen.

Die intrinsische Plagiatserkennung mittels Stilometrie kann die Grenzen der Textähnlichkeit bis zu einem gewissen Grad überwinden, indem man sprachliche Ähnlichkeiten vergleicht. Da die stilistischen Unterschiede zwischen plagiierten und originalen Segmenten erheblich sind und zuverlässig identifiziert werden können, kann die Stilometrie bei der Identifizierung von getarnten und paraphrasierten Plagiaten helfen . Stilometrische Vergleiche werden wahrscheinlich scheitern, wenn Abschnitte so stark umschrieben sind, dass sie dem persönlichen Schreibstil des Plagiators eher entsprechen oder wenn ein Text von mehreren Autoren verfasst wurde. Die Ergebnisse der Internationalen Wettbewerbe zur Plagiaterkennung 2009, 2010 und 2011 sowie von Stein durchgeführte Experimente zeigen, dass die stilometrische Analyse nur bei Dokumentenlängen von mehreren tausend oder zehntausend Wörtern zuverlässig zu funktionieren scheint, was die Anwendbarkeit der Methode auf CaPD-Einstellungen.

Zunehmend wird an Methoden und Systemen geforscht, die übersetzte Plagiate erkennen können. Gegenwärtig wird die sprachübergreifende Plagiatserkennung (CLPD) nicht als ausgereifte Technologie angesehen und entsprechende Systeme konnten in der Praxis keine zufriedenstellenden Erkennungsergebnisse erzielen.

Die zitationsbasierte Plagiatserkennung mittels Zitationsmusteranalyse ist im Vergleich zu anderen Erkennungsansätzen in der Lage, stärkere Paraphrasen und Übersetzungen mit höheren Erfolgsraten zu identifizieren, da sie unabhängig von textlichen Merkmalen ist. Da die Zitationsmusteranalyse jedoch von der Verfügbarkeit ausreichender Zitationsinformationen abhängt, ist sie auf wissenschaftliche Texte beschränkt. Es bleibt textbasierten Ansätzen bei der Erkennung kürzerer plagiierter Passagen unterlegen, die für Fälle von Copy-and-Paste- oder Shake-and-Paste-Plagiaten typisch sind; letzteres bezieht sich auf das Mischen leicht veränderter Fragmente aus verschiedenen Quellen.

Software

Das Design von Software zur Erkennung von Inhaltsähnlichkeiten zur Verwendung mit Textdokumenten wird durch eine Reihe von Faktoren gekennzeichnet:

| Faktor | Beschreibung und Alternativen |

|---|---|

| Umfang der Suche | Im öffentlichen Internet über Suchmaschinen / Institutionelle Datenbanken / Lokale, systemspezifische Datenbank. |

| Analysezeit | Verzögerung zwischen der Einreichung eines Dokuments und der Bereitstellung der Ergebnisse. |

| Dokumentenkapazität / Stapelverarbeitung | Anzahl der Dokumente, die das System pro Zeiteinheit verarbeiten kann. |

| Intensität prüfen | Wie oft und für welche Arten von Dokumentfragmenten (Absätze, Sätze, Wortfolgen fester Länge) fragt das System externe Ressourcen wie Suchmaschinen ab. |

| Vergleichsalgorithmustyp | Die Algorithmen, die definieren, wie das System Dokumente miteinander vergleicht. |

| Präzision und Rückruf | Anzahl der korrekt als plagiiert gekennzeichneten Dokumente im Vergleich zur Gesamtzahl der gekennzeichneten Dokumente und der Gesamtzahl der tatsächlich plagiierten Dokumente. Hohe Präzision bedeutet, dass nur wenige falsch-positive Ergebnisse gefunden wurden, und ein hoher Recall bedeutet, dass nur wenige falsch-negative Ergebnisse unentdeckt geblieben sind. |

Die meisten großen Plagiatserkennungssysteme verwenden große interne Datenbanken (zusätzlich zu anderen Ressourcen), die mit jedem zusätzlichen zur Analyse eingereichten Dokument wachsen. Diese Funktion wird jedoch von einigen als Verstoß gegen das Urheberrecht der Schüler angesehen .

Im Quellcode

Plagiate im Computerquellcode sind ebenfalls häufig und erfordern andere Werkzeuge als die, die für Textvergleiche in Dokumenten verwendet werden. Dem akademischen Quellcode-Plagiat wurden bedeutende Forschungsarbeiten gewidmet.

Eine Besonderheit von Quellcode-Plagiaten besteht darin, dass es keine Essay Mills gibt , wie sie beim traditionellen Plagiat zu finden sind. Da die meisten Programmieraufgaben von den Studierenden erwarten, dass sie Programme mit sehr spezifischen Anforderungen schreiben, ist es sehr schwierig, bestehende Programme zu finden, die diese bereits erfüllen. Da die Integration von externem Code oft schwieriger ist, als ihn von Grund auf neu zu schreiben, entscheiden sich die meisten plagiierenden Studenten dafür, dies von ihren Kollegen zu tun.

Laut Roy und Cordy können Algorithmen zur Erkennung von Quellcode-Ähnlichkeit klassifiziert werden als basierend auf entweder

- Strings – Suchen Sie nach exakten Textübereinstimmungen von Segmenten, zum Beispiel Fünf-Wort-Läufen. Schnell, kann aber durch Umbenennen von Bezeichnern verwechselt werden.

- Token – wie bei Strings, aber mit einem Lexer , um das Programm zuerst in Token umzuwandeln . Dadurch werden Leerzeichen, Kommentare und Bezeichnernamen verworfen, wodurch das System robuster gegenüber einfachen Textersetzungen wird. Die meisten akademischen Plagiatserkennungssysteme arbeiten auf dieser Ebene und verwenden verschiedene Algorithmen, um die Ähnlichkeit zwischen Tokensequenzen zu messen.

- Parse-Bäume – Erstellen und vergleichen Sie Parse-Bäume. Dadurch können Ähnlichkeiten auf höherer Ebene erkannt werden. Zum Beispiel kann der Baumvergleich bedingte Anweisungen normalisieren und äquivalente Konstrukte als einander ähnlich erkennen.

- Programmabhängigkeitsgraphen (PDGs) – Ein PDG erfasst den tatsächlichen Steuerungsfluss in einem Programm und ermöglicht das Auffinden von Äquivalenzen auf viel höherer Ebene mit einem höheren Aufwand an Komplexität und Rechenzeit.

- Metriken – Metriken erfassen „Scores“ von Codesegmenten nach bestimmten Kriterien; zum Beispiel "die Anzahl der Schleifen und Bedingungen" oder "die Anzahl der verschiedenen verwendeten Variablen". Metriken sind einfach zu berechnen und können schnell verglichen werden, können aber auch zu falsch-positiven Ergebnissen führen: Zwei Fragmente mit denselben Werten auf einem Satz von Metriken können völlig unterschiedliche Dinge bewirken.

- Hybride Ansätze – zum Beispiel können Parse-Bäume + Suffix-Bäume die Erkennungsfähigkeit von Parse-Bäumen mit der Geschwindigkeit von Suffix-Bäumen, einer Art von String-Matching-Datenstruktur, kombinieren.

Die bisherige Klassifikation wurde für das Code-Refactoring entwickelt und nicht für die akademische Plagiatserkennung (ein wichtiges Ziel des Refactorings ist die Vermeidung von doppeltem Code , in der Literatur als Code-Klone bezeichnet). Die obigen Ansätze sind gegen unterschiedliche Ähnlichkeitsniveaus wirksam; Ähnlichkeit auf niedrigem Niveau bezieht sich auf identischen Text, während Ähnlichkeit auf hohem Niveau auf ähnliche Spezifikationen zurückzuführen sein kann. In einer akademischen Umgebung, in der von allen Schülern erwartet wird, dass sie nach den gleichen Spezifikationen kodieren, wird vollständig funktional äquivalenter Code (mit hoher Ähnlichkeit) erwartet, und nur eine geringe Ähnlichkeit wird als Beweis für Betrug angesehen.

Komplikationen bei der Verwendung von Text-Matching-Software zur Plagiatserkennung

Bei der Verwendung von Text-Matching-Software zur Plagiatserkennung wurden verschiedene Komplikationen dokumentiert. Eine der am weitesten verbreiteten Bedenken betrifft die Frage der Rechte des geistigen Eigentums. Das grundlegende Argument ist, dass Materialien zu einer Datenbank hinzugefügt werden müssen, damit das TMS eine Übereinstimmung effektiv feststellen kann, aber das Hinzufügen von Materialien von Benutzern zu einer solchen Datenbank kann ihre geistigen Eigentumsrechte verletzen. Das Thema wurde in mehreren Gerichtsverfahren aufgeworfen.

Eine zusätzliche Komplikation bei der Verwendung von TMS besteht darin, dass die Software nur genaue Übereinstimmungen mit anderen Texten findet. Es greift beispielsweise schlecht paraphrasierte Arbeit oder die Praxis des Plagiierens durch Verwendung ausreichender Wortersetzungen auf, um sich einer Erkennungssoftware zu entziehen, die als Rogeting bekannt ist .

Siehe auch

- Kategorie:Plagiat-Detektoren

- Vergleich von Anti-Plagiat-Software

- Lokalitätssensitives Hashing

- Nächster Nachbar suchen

- Paraphrasenerkennung

- Kolmogorov-Komplexität#Kompression – wird verwendet, um die Ähnlichkeit zwischen Token-Sequenzen in mehreren Systemen abzuschätzen

Verweise

Literatur

- Carroll, J. (2002). Ein Handbuch zur Abschreckung von Plagiaten im Hochschulbereich . Oxford: Oxford Centre for Staff and Learning Development, Oxford Brookes University. (96 S.), ISBN 1873576560

- Zeidman, B. (2011). Das Handbuch des Software-IP-Detektivs . Lehrlingssaal. (480 S.), ISBN 0137035330